July–August 2025

تیر-مرداد 1404

دانشکده مدیریت هاروارد

از مجموعه “مدیریت ریسک”

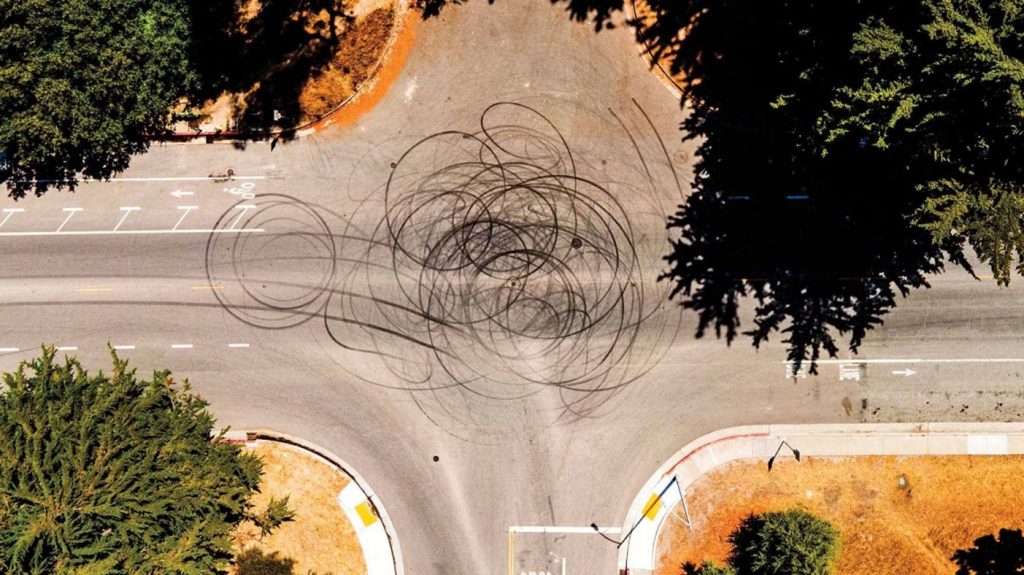

در اکتبر ۲۰۲۳ یک خودروی خودران که توسط شرکت کروز زیرمجموعه روباتاکسی جنرال موتورز اداره میشد، در سانفرانسیسکو دچار یک تصادف جدی شد. یک خودروی نیسان که توسط یک راننده انسانی هدایت می شد، به یک عابر برخورد کرد و او به مسیر خودروی خودران پرتاب شد.

بر اساس بررسی یک مشاور مهندسی مستقل، هیچ راننده انسانی عاقل و محتاطی در چنین شرایطی قادر به هدایت خودرو برای جلوگیری از تصادف نبود. با این حال، گزارش اولیه کروز به ناظران، این واقعیت را که عابر پس از برخورد به مدت ۲۰ فوت زیر خودرو کشیده شده بود، حذف کرد. او دچار جراحات شدید شد اما زنده ماند.

با اینکه کروز مسئول تصادف نبود این حادثه، بحران بزرگی برای شرکت ایجاد کرد. عدم شفافیت آنها باعث شد اداره ملی ایمنی ترافیک بزرگراهها جریمهای ۱.۵ میلیون دلاری برایشان تعیین کند و تحقیقات کیفری توسط وزارت دادگستری آغاز شد؛ پرونده در نهایت با پرداخت ۵۰۰ هزار دلار جریمه حل و فصل شد.

ولی ماجرا به همینجا ختم نشد. مجوز فعالیت شرکت در سانفرانسیسکو لغو شد، نیمی از کارکنان کروز شغل خود را از دست دادند، مدیرعامل استعفا داد و ارزش شرکت بیش از ۵۰٪ کاهش یافت. این بحران، صنعت خودروهای خودران را هم تکان داد. چند ماه بعد، یک تاکسی بدون راننده وایمو زیرمجموعه آلفابت در سانفرانسیسکو مورد حمله قرار گرفت و به آتش کشیده شد و اداره ایمنی بزرگراه ها تحقیقات خود را روی چندین توسعهدهنده خودروهای خودران، از جمله وایمو و زوکس زیرمجموعه آمازون آغاز کرد. تا پایان سال ۲۰۲۴ جنرال موتورز اعلام کرد که توسعه کسبوکار روبا تاکسی خود را کاملاً متوقف خواهد کرد.

هوش مصنوعی در حال حاضر بهسرعت در حوزههای مختلف، از خودروها تا چتباتها مورد استفاده قرار میگیرد، اما مثال کروز واقعیتی تلخ را نشان میدهد: نهایتاً، هوش مصنوعی هم ممکن است شکست بخورد. وقتی این اتفاق میافتد، بسیاری از سازمانها چه سیستمهای هوش مصنوعی خود را ساخته باشند و چه از سیستمهای دیگران استفاده کنند در معرض نقد و بررسی عمومی قرار میگیرند. اگرچه تاکنون مطالب زیادی درباره چگونگی بازاریابی هوش مصنوعی برای افزایش پذیرش آن نوشته شده است، اما به نحوه بازاریابی هوش مصنوعی به شکلی که سازمانها را برای شکستهای اجتنابناپذیر آن آماده کند، توجه کمتری شده است.

در هفت سال گذشته، من هفت پژوهش درباره خطرات شکست هوش مصنوعی از زاویه بازاریابی انجام دادهام. نتیجه این تحقیقات نشان میدهد که مصرفکنندگان، شکستهای هوش مصنوعی را چگونه میبینند و چه واکنشی به آن نشان میدهند. بازاریابان حرفهای باید به پنج دام مهم در نگرش مصرفکنندگان توجه داشته باشند، هم قبل از بروز مشکل و هم بعد از آن.

در این مقاله توضیح میدهم که شرکتها چطور باید خود را برای خطاهای هوش مصنوعی آماده کنند و وقتی سیستمها درست عمل نمیکنند، چه کاری باید انجام دهند. همچنین بررسی میکنم شرکتها چگونه هوش مصنوعی خود را معرفی و تبلیغ میکنند و آیا این روشها میتواند برایشان ریسک ایجاد کند یا نه. در ادامه، نمونههایی از واکنش سازمانها به شکستهای هوش مصنوعی را مرور میکنم و توصیههای کاربردی به مدیرانی ارائه میدهم که میخواهند ضمن معرفی هوش مصنوعی خود، از برندشان محافظت کنند و اعتماد مشتریان را افزایش دهند.

1- مردم معمولاً هوش مصنوعی را اولین متهم می دانند

برای اینکه بهتر بفهمیم چرا واکنش افکار عمومی و نهادهای نظارتی به حادثه کروز اینقدر شدید بود، من و همکارانم پژوهشی با بیش از ۵ هزار نفر انجام دادیم. در این پژوهش، سناریوی یک تصادف را برای شرکتکنندگان توضیح دادیم که بسیار شبیه اتفاق کروز بود؛ جایی که یک راننده انسانی با یک عابر برخورد میکند و عابر به مسیر خودروی دومی پرت میشود که هیچ تقصیری در حادثه نداشته است.

به یک گروه گفته شد خودروی بدون تقصیر، خودران بوده و به گروه دیگر گفته شد که همان خودرو توسط یک انسان، رانده میشده است. بعد از آن، از شرکتکنندگان خواستیم نظرشان را درباره میزان مسئولیت شرکت سازنده خودرو اعلام کنند.

شرکتکنندگان، زمانی که خودروی بدون تقصیر، خودران بود، مسئولیت بیشتری را متوجه شرکت سازنده آن میدانستند تا زمانی که همان خودرو توسط انسان هدایت میشد؛ حتی با وجود اینکه در هر دو حالت، خودرو هیچ کاری برای جلوگیری از تصادف نمیتوانست انجام دهد. آنها همچنین وقتی خودروی بدون تقصیر توسط انسان رانده میشد، شرکت سازنده خودروی خودران را مسئولتر از راننده انسانی همان خودرو ارزیابی کردند.

این یافته بعدها توسط یک گروه پژوهشی مستقل در چین هم تأیید شد و نشان داد این نوع نگاه منفی نسبت به هوش مصنوعی در فرهنگهای مختلف وجود دارد.

در آزمایشهای بعدی دیدیم وقتی تمرکز مردم به سمت راننده انسانی مقصر—کسی که ابتدا باعث تصادف شده بود—برود، میزان سرزنش هوش مصنوعی کاهش مییابد. وقتی توجه افراد از تازگی خودروی خودران به دیگر عوامل مهم جلب شود، کمتر سناریوهای غیرواقعی و خیالی میسازند.

با این حال، کمکردن تمرکز از «تازهبودن» فناوری با گمراهکردن عمدی تفاوت دارد: مدیران نباید نقش هوش مصنوعی در بروز حادثه را پنهان کنند. هرچند مدیران کروز تقصیر را به راننده انسانی نسبت دادند، اما آسیبی که خودرو با کشیدن عابر ایجاد کرده بود را افشا نکردند. وقتی این موضوع فاش شد، کروز کنترل روایت رسانهای را از دست داد و اعتماد نهادهای نظارتی به شرکت آسیب دید.

2- وقتی یک هوش مصنوعی شکست میخورد، مردم اعتمادشان به سایر هوشهای مصنوعی را هم از دست می دهند

پیامدهای حادثه کروز برای شرکتهایی مثل وایمو و زوکس نشان میدهد یک خطر دیگر شکست هوش مصنوعی این است: وقتی سیستم هوش مصنوعی یک شرکت خراب میشود، مردم معمولاً فکر میکنند سیستمهای مشابه شرکتهای دیگر هم مشکل دارند. این اثرِ «انتقال بدنامی» میتواند دید عمومی نسبت به همه انواع هوش مصنوعی را منفی کند.

یک مطالعه که توسط پروفسور چیارا لانگونی و همکارانش انجام شد، نمونه خوبی از نحوه وقوع «انتقال بدنامی» شکست را نشان میدهد. آنها به ۳۷۲۴ نفر درباره یک مشکل اطلاع دادند: ایالت آرکانزاس نتوانسته بود مزایای معلولیت را بهدرستی به یک فرد دارای معلولیت اختصاص دهد. به برخی از شرکتکنندگان گفته شد که یک کارمند انسانی مقصر بوده و به برخی دیگر گفته شد که یک الگوریتم، مقصر بوده است. سپس از آنها پرسیده شد که چقدر احتمال دارد یک کارمند یا الگوریتم در ایالت دیگر (کنتاکی) هم در تخصیص مزایای معلولیت دچار خطا شود.

نتایج نشان داد شرکتکنندگان بیشتر احتمال میدادند که الگوریتم دچار خطا شود تا یک انسان در کنتاکی. پژوهشگران این اثر را در مورد دیگر شکستهای هوش مصنوعی، مانند تخصیص نادرست پرداختهای تامین اجتماعی، نیز تکرار کردند.

پژوهشگران متوجه شدند که دلیل این واکنش مردم، درک ناقص آنها از نحوه کار هوش مصنوعی است. بسیاری از افراد فکر میکنند همه سیستمهای هوش مصنوعی شبیه هم هستند و ویژگیها و ضعفهای یکسانی دارند، در حالی که هر سیستم هوش مصنوعی، تواناییها و محدودیتهای خاص خودش را دارد.

برای اینکه شکستهای هوش مصنوعی دیگر شرکتها روی برند شما تأثیر منفی نگذارد، باید نشان دهید سیستمهای هوش مصنوعی شما با محصول رقبایتان فرق دارند. بر ویژگیهای متمایز خود، مثل الگوریتمهای اختصاصی، اقدامات ایمنی و نظارت انسانی تأکید کنید. به عنوان نمونه، شرکت آنتروپیک مدل هوش مصنوعی مولد خود، کلود، را اینگونه معرفی میکند:”یک دستیار هوش مصنوعی نسل بعد… آموزش دیده تا ایمن، دقیق و قابل اعتماد باشد و به شما کمک کند بهترین عملکردتان را ارائه دهید.”آنتروپیک همچنین توضیح میدهد که چگونه کلود را آموزش میدهد . . .

شرکت آنتروپیک از رویکردی «قانونمند» استفاده میکند که شفاف، قابل فهم و همسو با ارزشهای انسانی است. این کار به آنها کمک میکند کلود را از مدلهای محبوب رقیب مثل چت جی پی تی و بارد جدا کنند؛ مدلهایی که روش آموزش متفاوتی دارند و گاهی به جانبداری یا ارائه اطلاعات نادرست متهم شدهاند. اگر هر یک از این رقبای دیگر شکست بخورند، آنتروپیک از قبل اقداماتی انجام داده تا اثرات منفی این شکستها روی برند خود را به حداقل برساند.

یکی دیگر از راههای پیشگیری این است که نشان دهید یک انسان بر عملکرد هوش مصنوعی نظارت دارد و تصمیم میگیرد که توصیههای آن اجرا شوند یا نه. وقتی در چنین سازوکاری شکست رخ میدهد، مردم کمتر احتمال میدهند که سایر سیستمهای هوش مصنوعی هم خراب باشند، چون آنها این شکست را بهطور کلی به هوش مصنوعی نسبت نمیدهند.

3- مردم شرکتهایی را که توانایی هوش مصنوعی را بزرگنمایی میکنند، بیشتر سرزنش میکنند

شرکت تسلا سیستم کمکراننده خود را اتوپایلوت مینامد، با اینکه برای استفاده از آن، راننده باید همیشه مراقب باشد. پس از چند تصادف مرگبار خودروهای تسلا در حالت اتوپایلوت، این شرکت با پروندههای قضایی مواجه شد، از جمله تحقیقی توسط وزارت دادگستری برای بررسی اینکه آیا این نامگذاری گمراهکننده است یا نه. همچنین اداره ملی ایمنی ترافیک بزرگراهها از تسلا خواسته است تا پیامهای عمومی خود را طوری اصلاح کند که قابلیتها و محدودیتهای سیستم را دقیقتر نشان دهند.

مدیرعامل تسلا، ایلان ماسک، استفاده از نام اتوپایلوت را با اشاره به صنعت هوانوردی توجیه میکند، جایی که این واژه کمک به خلبانها را تداعی می کند و به معنای سیستم کاملاً خودران نیست. اما آیا مصرفکنندگان این برداشت را دارند؟

من و همکارانم مسئله بزرگنمایی هوش مصنوعی را در مطالعهای با ۹۴۹۲ شرکتکننده بررسی کردیم، با استفاده از شبیهساز رانندگی و سناریوهای فرضی تصادف. به یک گروه گفته شد خودروی جدید اتوپایلوت نام دارد (نشانه توانایی بالای هوش مصنوعی) و به گروه دیگر گفته شد نام آن کوپایلوت است (نشانه توانایی متوسط هوش مصنوعی). شرکتکنندگان سپس وارد یک شبیهسازی رانندگی شدند و هر زمان که احساس کردند نیاز است، میتوانستند کنترل فرمان را در دست بگیرند. در این سناریو، خودرو به یک چهارراه شلوغ نزدیک میشد و تا وقتی شرکتکننده مداخله نمیکرد، با عابران پیاده برخورد داشت.

نتایج نشان داد که شرکتکنندگان وقتی خودرو، اتوپایلوت نام داشت نسبت به زمانی که نام آن کوپایلوت بود، دیرتر وارد عمل شده و کنترل فرمان را به دست میگرفتند. این نشان میدهد خودِ نام خودرو باعث اعتماد بیش از حد و راحتطلبی آنها شده بود. هر چه تصور میکردند خودرو توانایی بیشتری دارد—همانطور که از نامش برداشت میشد—دیرتر مداخله میکردند.

مطالعات دیگر نیز نشان داد مردم وقتی شرکتها از نامهایی استفاده میکنند که توانایی بالاتر هوش مصنوعی را القا میکنند، بیشتر آنها را مسئول تصادف میدانند. این یعنی چنین نامگذاریهایی، هم رفتار پرخطر مصرفکننده را افزایش میدهد و هم میزان سرزنش شرکت در صورت وقوع شکست را بیشتر میکند.

بر اساس این نتایج، من و همکارانم فرض کردیم که یک رویکرد رایج بازاریابی ممکن است هنگام شکست هوش مصنوعی نتیجهٔ معکوس بدهد: بزرگنمایی محصول خود و برتر نشان دادن آن نسبت به رقبا. مطالعات بعدی ما این فرضیه را تأیید کرد: وقتی شرکتها این کار را انجام میدادند، توانایی سیستمهای خود را در نظر مخاطبان بالاتر جلوه داده و بهطور غیرعمدی باعث میشدند شرکتکنندگان میزان مسئولیت آنها در صورت وقوع شکست را بیشتر ببینند.

این یافته نشان میدهد کمپینهای تبلیغاتی مانند جنرال موتورز با شعار «انسانها در تصادفها فاجعه هستند» ممکن است در تصادفهایی که بعداً رخ داد، نتیجه معکوس داشته باشند.

این اثرات به این دلیل رخ میدهد که سیستمهای هوش مصنوعی میتوانند طیف وسیعی، از خودران جزئی (که در آن انسان مسئول اصلی عملکرد سیستم است) تا خودران کامل (که در آن هوش مصنوعی کنترل را در دست دارد) را در بر بگیرند. با این حال، بیشتر مصرفکنندگان نمیدانند هر سیستم هوش مصنوعی دقیقاً در کجای این طیف قرار دارد. این موضوع برای بازاریابان یک معضل ایجاد میکند: تبلیغات صادقانه توانایی واقعی سیستم را نشان میدهند، اما شرکتها اغلب وسوسه میشوند از تبلیغاتی استفاده کنند که قابلیتها را بزرگنمایی میکند تا فروش افزایش یابد.

اگر برای تبلیغ هوش مصنوعی خود از مفهومی استفاده میکنید که توانایی واقعی آن را بزرگنمایی میکند، حتماً در جای دیگری—مثل وبسایت یا توضیحات محصول—بهطور شفاف و دقیق قابلیتهای واقعی سیستم را توضیح دهید. تحقیقات من نشان میدهد شرکتهایی که هم تبلیغ جذاب و هم اطلاعات واقعی سیستم را ارائه میکنند، نسبت به شرکتهایی که فقط از تبلیغ گمراهکننده استفاده میکنند، هنگام بروز خطا، کمتر جریمه و سرزنش میشوند.

راه سادهتر این است که از همان ابتدا از تبلیغ صادقانه و کمگمراهکننده استفاده کنید. شاید این کار توانایی سیستم را بیش از حد نشان ندهد، اما حداقل هیچ ریسکی برای شرکت ندارد.

4- مردم هوش مصنوعیهایی را که شبیه انسان طراحی شدهاند، سختگیرانهتر قضاوت میکنند

شرکتها روزبهروز بیشتر از سیستمهای هوش مصنوعی استفاده میکنند که ویژگیهای انسانی دارند. برای مثال ویسا یک اپلیکیشن سلامت روان، از یک شخصیت کارتونی استفاده میکند که به افراد در انجام تمرینها کمک میکند، و اپلیکیشنهای همراه هوش مصنوعی مانند رپلیکا از تصاویر واقعی انسان استفاده میکنند که «احساسات» و «تفکرات» را نشان میدهند.

این نشانهها میتوانند این تصور را ایجاد کنند که ربات دارای احساسات، اهداف، خواستهها و ویژگیهای شخصی است—در حالی که در واقع چنین ویژگیهایی ندارد. رباتهایی که انسانگونه طراحی شدهاند، نسبت به رباتهای معمولی برای شرکتها مزایای متعددی دارند: آنها تمایل مصرفکنندگان به خرید، میزان اعتماد، وفاداری به برند، پیروی از درخواستهای ارائهدهنده و تمایل به افشای اطلاعات شخصی را افزایش میدهند. این اثرات حتی زمانی که مردم میدانند با یک ماشین صحبت میکنند نیز باقی میماند.

در مطالعهای که توسط پروفسور راجی سیرینی واسان و همکارش انجام شد، به شرکتکنندگان درباره یک شرکت سرمایهگذاری توضیح داده شد که مرتکب خطا شده و باعث ضرر مشتریان شده است. به یک گروه گفته شد این خطا توسط یک «برنامه الگوریتمی» رخ داده و به گروه دیگر گفته شد یک هوش مصنوعی انسانگونه به نام چارلز مسئول بوده است. نتایج نشان داد نگرش نسبت به برند وقتی الگوریتم، انسانگونه شده بود، منفیتر است.

مطالعات بعدی نشان داد رباتهای انسانگونه بیشتر به ویژگیهای ذهنی مانند یادآوری، درک، برنامهریزی و تفکر نسبت داده میشوند، و همین باعث میشود مسئولیت بیشتری به آنها نسبت به شکستها داده شود.

در مطالعه دیگری، تیمی به رهبری کمی کرولیک دریافت که شرکتکنندگان، یک چتبات ناکام را وقتی هم از نشانههای کلامی و هم تصویری انسانگونه استفاده میکرد (مثل زبان اول شخص، معرفی خود با نام Jamie و داشتن آواتار زنانه)، نسبت به زمانی که فقط از نشانههای کلامی استفاده میکرد، منفیتر ارزیابی کردند. این نشان میدهد ویژگیهای انسانگونه، اثر جمعشوندهای روی واکنش منفی به شکست دارند.

باید در استفاده از چتباتها در موقعیتهایی که مشتریان ممکن است عصبانی شوند، بسیار محتاط باشید. در مطالعهای دیگر به رهبری کرولیک حدود ۵۰۰,۰۰۰ جلسه چتبات مشتریان یک شرکت بینالمللی مخابراتی بررسی و مشخص شد هرچه مشتریان، چتبات را بیشتر شبیه یک انسان حس کنند—مثلاً از نام کوچک آن در گفتگو استفاده کنند—رضایتشان هنگام عصبانیت کاهش مییابد.

برای کاهش این مشکل، میتوان رباتهای انسانگونه را فقط در حوزههای خنثی مانند جستجوی محصولات به کار برد و کمتر در نقشهایی که معمولاً با مشتریان عصبانی سروکار دارند، مثل مراکز خدمات مشتری به کار برد. روش دیگر این است که از همان ابتدا انتظارات مشتری را مدیریت کنید. برای مثال، چتبات اسلک با پیامی مانند: «سلام، من اسلک بات هستم. سعی میکنم کمک کنم، اما هنوز فقط یک رباتم. ببخشید!» خود را معرفی میکند. رباتهایی که چنین توضیحاتی میدهند، هنگام شکست، کمتر باعث عصبانیت مشتریان میشوند.

5– مردم از اینکه هوش مصنوعی یا برنامهها تصمیماتشان را از قبل تعیین میکنند، عصبانی میشوند

در سال ۲۰۱۶ یک مدیر ارشد در مرسدسبنز اعلام کرد که هنگام توسعه خودروهای خودران، ایمنی سرنشینان را بر ایمنی عابران و دیگر کاربران جاده ترجیح میدهند. منطق او ساده بود: اگر فقط یک جان قابل نجات باشد، باید جان فرد داخل خودرو حفظ شود. این اظهارنظر باعث جنجال خبری شد؛ یک روزنامه زرد حتی تیتر زد که شرکت”ترجیح میدهد یک کودک را زیر بگیرد تا سرنشینان خودرو را نجات دهد.”

چند هفته بعد، مرسدسبنز رسماً اعلام کرد که نه مهندسان و نه سیستمهای خودران نباید درباره ارزش نسبی جان انسانها تصمیمگیری کنند. واکنشهای احساسی این حادثه نشان میدهد مردم اخلاقی نمیدانند که شرکتها عمداً ترجیحات گروهی—مثلاً بر اساس سن، جنسیت یا وضعیت مشتری—را در سیستمهای هوش مصنوعی برنامهریزی کنند.

برای آزمایش این فرضیه، من همراه با پروفسور مینا سیکارا از دانشگاه هاروارد مطالعهای انجام دادیم و از ۸۲۶ شرکتکننده در ایالات متحده خواستیم تصور کنند که یک خودروی کاملاً خودران با چند معضل دشوار روبهروست—مثلاً اینکه به سمت یک فرد سالمند یا یک کودک خردسال منحرف شود—و در نهایت با یکی از این دو گروه برخورد میکند. نکته مهم این بود که ما بررسی کردیم خودرو، تصمیم خود را به صورت تصادفی میگیرد یا بر اساس برنامهای که یک گروه را بر گروه دیگر اولویت میدهد.

نتایج نشان داد که شرکتکنندگان وقتی خودرو برنامهای داشت که گروهی را اولویت میداد، خشمگینتر بودند نسبت به وقتی که تصمیم به صورت تصادفی گرفته میشد. این نشان میدهد شرکتها ممکن است نخواهند اعلام کنند که سیستمهایشان بر اساس اولویتهای گروهی تصمیم میگیرند. در برخی موارد، حتی ممکن است بخواهند از جمعآوری دادههایی مانند نژاد، جنسیت و سن برای هدایت رفتار سیستمهای هوش مصنوعی اجتناب کنند.

راه دیگر این است که از ویژگیهای ساختاری موقعیت استفاده کنند، مانند اولویت دادن به نجات تعداد بیشتری انسان در مقابل تعداد کمتر. مطالعهای توسط بیگمن نشان داد که مردم بیشتر از سیستمهای هوش مصنوعی که از اولویتهای ساختاری استفاده میکنند، حمایت میکنند تا اولویتهای گروهی، احتمالاً به این دلیل که اولویتهای ساختاری دلیل واضح و منطقی دارند که بیشتر افراد با آن موافق هستند.

شکست هوش مصنوعی اجتنابناپذیر است. بازاریابان باید بدانند همان اقداماتی که امروز باعث جذب کاربران میشود، میتواند هنگام بروز شکست مشکلاتی ایجاد کند—بهویژه وقتی مزایا و برتریهای هوش مصنوعی خود را بزرگنمایی میکنند. بنابراین قبل از اجرای هر استراتژی بازاریابی، حتماً پنج چالش اصلی مرتبط با هوش مصنوعی را بشناسید. بررسی این ریسکها به شرکت کمک میکند بازاریابیای داشته باشد که هم فروش هوش مصنوعی را افزایش دهد و هم ریسک برند و مسئولیت شرکت را در صورت شکست آینده کاهش دهد.